Introducción

El conector Open AI para Bizagi está disponible para su descarga en Bizagi Connector XChange. A través de este conector, puedes utilizar diferentes modelos de lenguaje natural y tecnologías de inteligencia artificial. Este conector permite a los usuarios crear respuestas de competencia, creación de imágenes, chatbots, funciones de edición y moderación.

|

Este conector fue desarrollado de acuerdo con el contenido de la API y la información proporcionada por Open AI. Bizagi y sus subsidiarias no brindarán ningún tipo de garantía sobre el contenido o los errores causados al llamar a los servicios de la API. Bizagi y sus subsidiarias no se hacen responsables de ninguna pérdida, costo o daño causado por las llamadas a la API de Open AI. |

Antes de comenzar

Para probar y utilizar este conector, necesitarás:

1.Bizagi Studio instalado previamente.

2.Este conector instalado previamente, a través de Connectors XChange como se describe en https://help.bizagi.com/platform/en/index.html?Connectors_Xchange.htm, o mediante una instalación manual como se describe en https://help.bizagi.com/platform/en/index.html?connectors_setup.htm.

3.Generar tu propia clave de API según se describe en la documentación de Open AI.

Configuración del conector

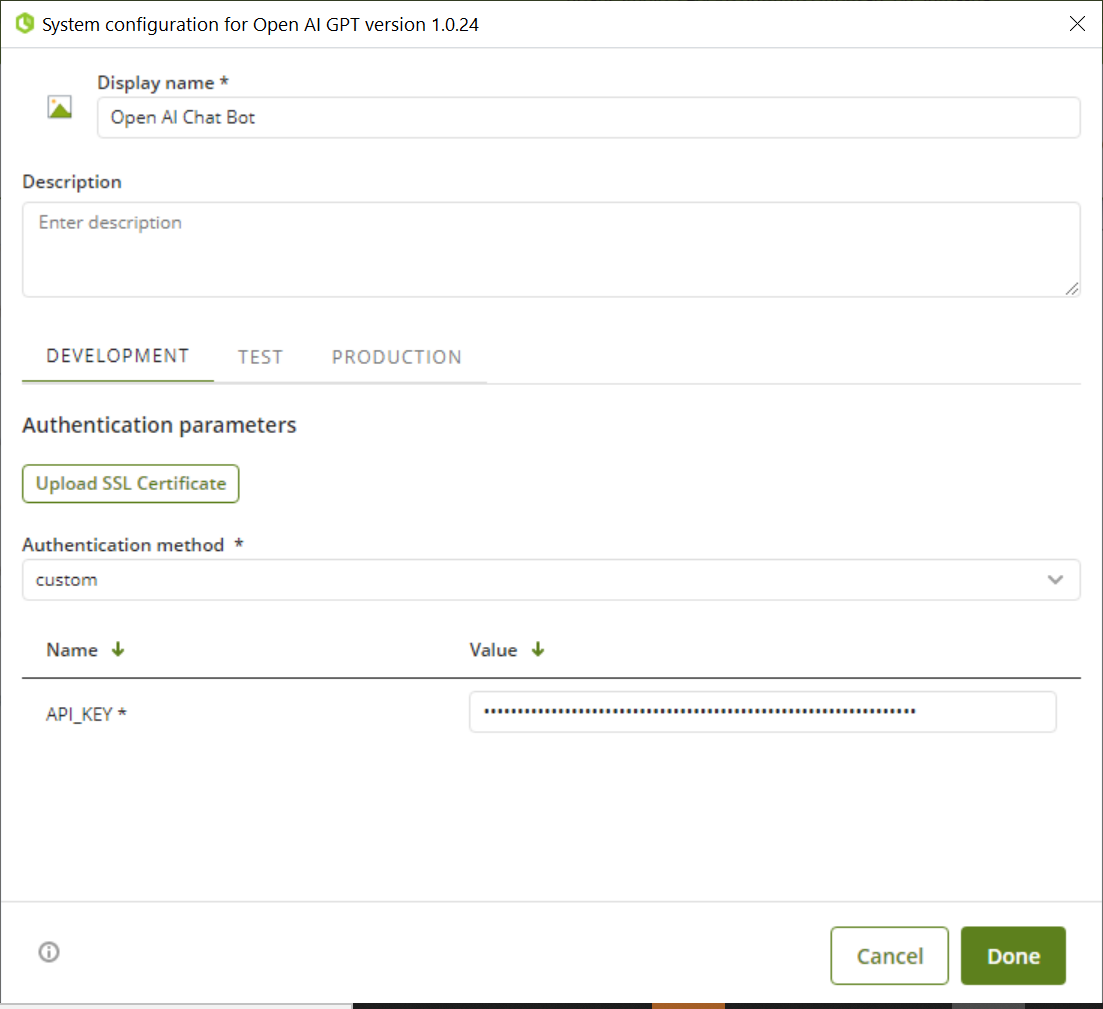

Para configurar el conector (en particular sus parámetros de autenticación), sigue los pasos presentados en el capítulo de Configuración en https://help.bizagi.com/platform/en/index.html?connectors_setup.htm.

Para esta configuración, considera los siguientes parámetros de autenticación:

•API_KEY: Llave de Open AI.

La configuración del conector debería lucir así:

Usando el conector

Este conector cuenta con un conjunto de métodos que te permiten utilizar los servicios de la API de Open AI para aprovechar sus capacidades.

Para obtener una visión general de cómo y dónde configurar el uso de un conector, consulta https://help.bizagi.com/platform/en/index.html?Connectors_Studio.htm.

Acciones disponibles

Crear chat

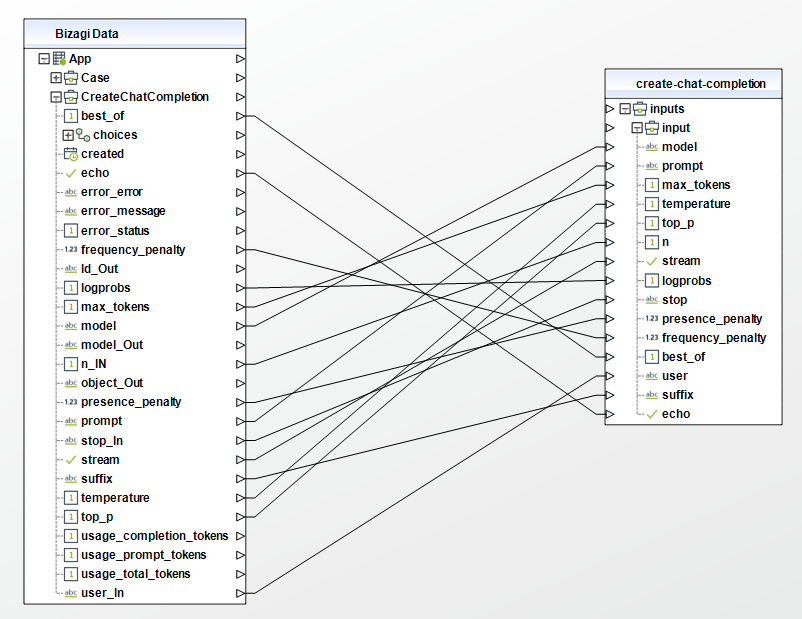

Con esta función, los usuarios pueden crear un chatbot impulsado por cualquiera de los modelos de procesamiento del lenguaje natural (NLP) disponibles de Open AI.

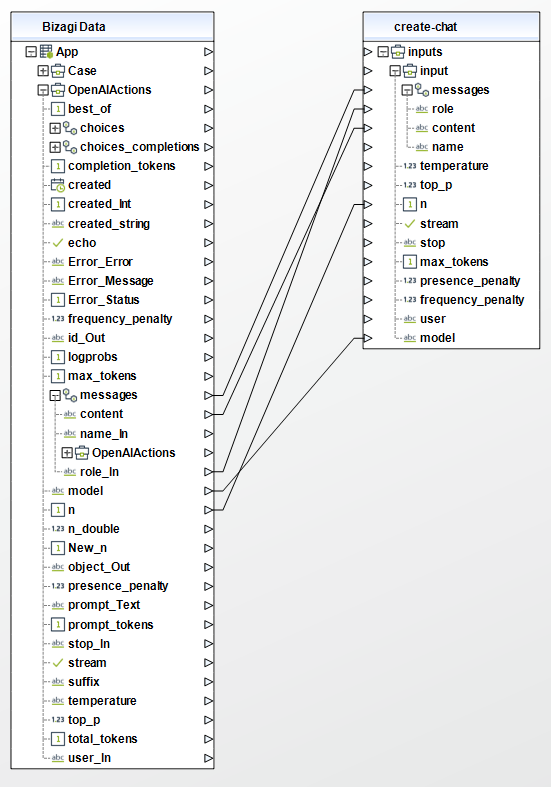

Para configurar sus entradas, ten en cuenta las siguientes descripciones:

•model (string - Requerido): ID del modelo a utilizar (gpt-4, gpt-4-0314, gpt-4-32k, gpt-4-32k-0314, gpt-3.5-turbo, gpt-3.5-turbo-0301). Consulta la tabla de compatibilidad de puntos finales de modelos para obtener detalles sobre qué modelos funcionan con la API de Chat.

•messages (array - Requerido): Una lista de mensajes que describen la conversación hasta ahora.

•role (string - Requerido): El rol del autor de este mensaje. Puede ser "system" (sistema), "user" (usuario) o "assistant" (asistente).

•content (string - Requerido): El contenido del mensaje.

Se pueden utilizar entradas adicionales, para obtener más información visita la documentación de Open AI sobre la creación de chats.

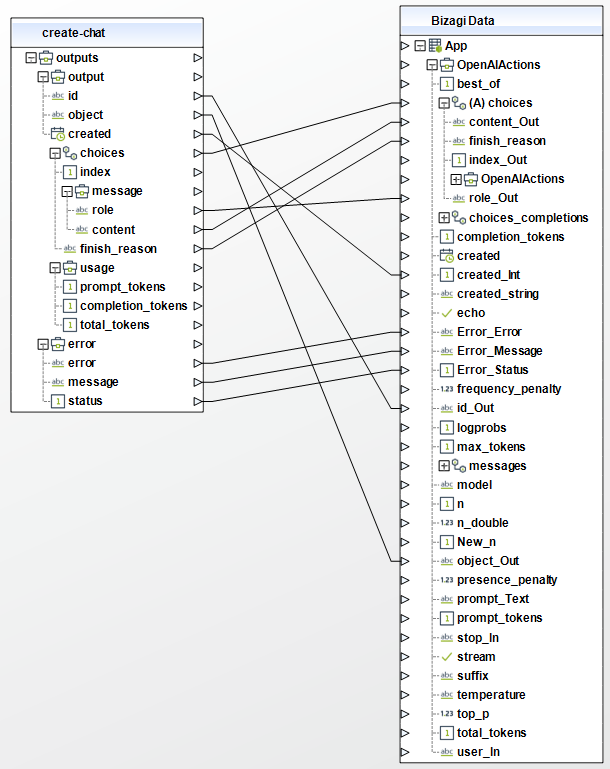

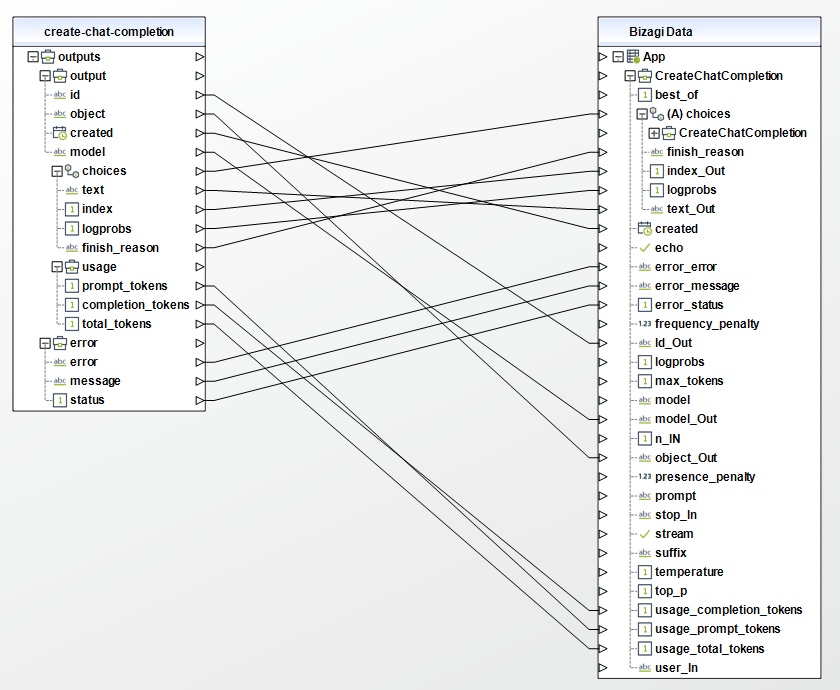

Para configurar las salidas de esta acción, puedes asignar el objeto de salida a la entidad correspondiente en Bizagi y asegurarte de asignar adecuadamente los atributos de la entidad.

Las salidas de este conector son las siguientes:

•id (string): Identificador de salida.

•object (string): Indica el tipo de objeto devuelto, en este caso, será "chat".

•created (date): Fecha de creación de la respuesta.

•choices (object - array):

oindex (integer): Número para identificar el elemento actual respondido.

omessage (object):

▪role (string): Rol del mensaje generado. Puede ser "system" (sistema), "user" (usuario) o "assistant" (asistente). El rol "system" se utiliza para mensajes generados por el sistema que brindan instrucciones o información adicional.

▪content (string): Respuesta a la pregunta de las entradas.

ofinish_reason (string): Proporciona información sobre por qué el modelo ha terminado de generar una respuesta. Puede ser "stop" si el modelo ha completado normalmente o "max_tokens" si se ha alcanzado el límite de tokens.

•usage (object):

oprompt_tokens (integer): Tokens utilizados para la respuesta.

ocompletion_tokens (integer): Tokens utilizados para completar.

ototal_tokens (integer): Tokens totales utilizados.

Crear imagen

Con esta función, el conector proporciona una cierta cantidad de imágenes relacionadas con un texto de entrada del usuario.

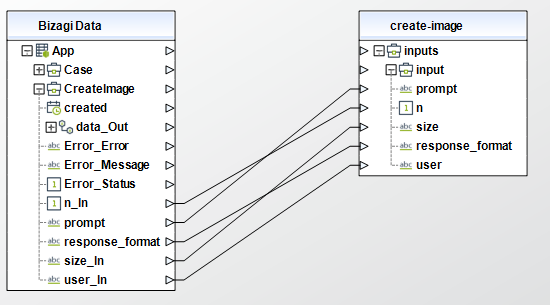

Para configurar sus entradas, ten en cuenta las siguientes descripciones:

•prompt (string - Requerido): Una descripción de texto de la(s) imagen(es) deseada(s). La longitud máxima es de 1000 caracteres.

•n (integer - opcional): El número de imágenes a generar. Debe ser entre 1 y 10.

•size (string - opcional): El tamaño de las imágenes generadas. Debe ser uno de los siguientes: 256x256, 512x512 o 1024x1024.

•response_format (string - opcional): El formato en el que se devuelven las imágenes generadas. Debe ser uno de los siguientes: url o b64_json.

•user (string - opcional): Un identificador único que representa a tu usuario final, lo cual puede ayudar a OpenAI a monitorear y detectar abusos.

Para obtener más información, visita la documentación de Open AI sobre la creación de imágenes.

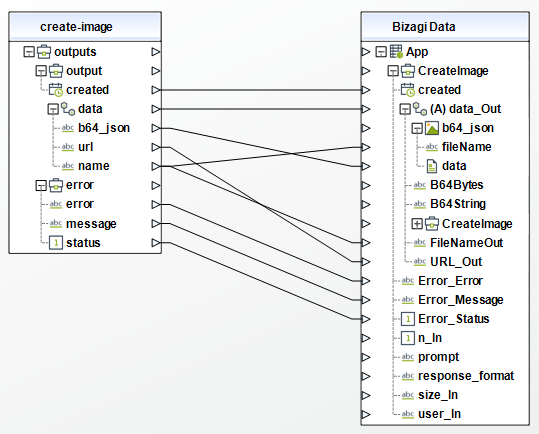

Para configurar las salidas de esta acción, puedes asignar el objeto de salida a la entidad correspondiente en Bizagi y asegurarte de asignar adecuadamente los atributos de la entidad.

Las salidas de este conector son las siguientes:

•created (date): Fecha de creación de la respuesta.

•data (object - array):

ourl (string): URL donde se puede descargar la imagen.

ob64_json (string): Base64 correspondiente a la imagen.

oname (string): Nombre de la(s) imagen(es) generada(s). Se construye con el siguiente formato: file_ + fecha actual + .png.

Crear completado

Con la función de completado, dado un texto de entrada del usuario, el modelo devolverá una o más completaciones predichas, y también puede devolver las probabilidades de los tokens alternativos en cada posición.

Para configurar sus entradas, ten en cuenta las siguientes descripciones:

•model (string - Requerido): ID del modelo a utilizar (text-davinci-003, text-davinci-002, text-curie-001, text-babbage-001, text-ada-001). Puedes utilizar la lista de modelos del API para ver todos los modelos disponibles o consultar la descripción general del modelo para obtener descripciones de los mismos.

•prompt (string - opcional): La(s) indicación(es) para generar completados, codificada(s) como una cadena. Ten en cuenta que \n es el separador de documentos que el modelo ve durante el entrenamiento, por lo que si no se especifica una indicación, el modelo generará como si fuera desde el principio de un nuevo documento.

•temperature (float - opcional): Qué temperatura de muestreo usar, entre 0 y 2. Valores más altos como 0.8 harán que la salida sea más aleatoria, mientras que valores más bajos como 0.2 la harán más enfocada y determinística.

•top_p (float - opcional): Una alternativa al muestreo con temperatura, llamada muestreo de núcleo, donde el modelo considera los resultados de los tokens con una masa de probabilidad de top_p. Entonces, 0.1 significa que solo se consideran los tokens que comprenden el 10% superior de la masa de probabilidad.

•stream (stream - opcional): Si se debe transmitir el progreso parcial. Si se establece, los tokens se enviarán como eventos enviados por el servidor de solo datos a medida que estén disponibles, y la transmisión se finalizará con un mensaje data: [DONE].

•n (integer - opcional): Cuántas completaciones generar para cada indicación.

Se pueden utilizar entradas adicionales, para obtener más información visita la documentación de Open AI sobre la creación de completados.

Para configurar las salidas de esta acción, puedes asignar el objeto de salida a la entidad correspondiente en Bizagi y asegurarte de asignar adecuadamente los atributos de la entidad.

Las salidas de este conector son las siguientes:

•id (string): Identificador de salida.

•object (string): Indica el tipo de objeto devuelto, en este caso, será "text_completion".

•created (date): Fecha de creación de la respuesta.

•model (string): Modelo utilizado para la entrada.

•choices (object - array):

oindex (integer): Número para identificar el elemento actual respondido.

otext (string): Respuesta a la pregunta de las entradas.

ologprobs (integer): Información adicional sobre la distribución de probabilidad de los tokens generados. Por ejemplo, null indica que los logprobs no están disponibles.

ofinish_reason (string): Proporciona información sobre por qué el modelo ha terminado de generar una respuesta. Puede ser "stop" si el modelo ha finalizado normalmente, o "max_tokens" si se ha alcanzado el límite de tokens.

•usage (object):

oprompt_tokens (integer): Tokens utilizados en la respuesta.

ocompletion_tokens (integer): Tokens utilizados en el completado.

ototal_tokens (integer): Tokens totales utilizados.

Create edit

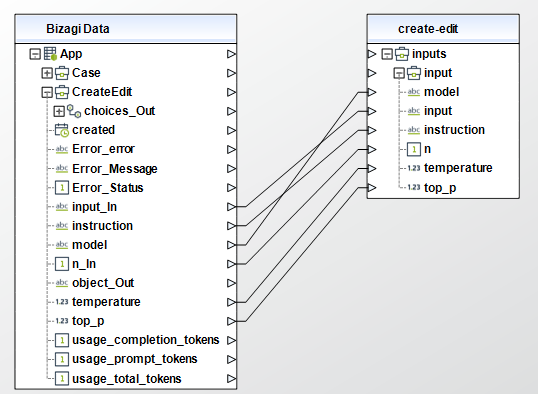

La función de edición te permite modificar la entrada del usuario en función de una indicación específica. Por ejemplo, puedes pedirle al conector que corrija la ortografía de la entrada del usuario.

Para configurar sus entradas, ten en cuenta las siguientes descripciones:

•model (string - Obligatorio): ID del modelo a utilizar (text-davinci-edit-001, code-davinci-edit-001). Puedes usar el modelo text-davinci-edit-001 o code-davinci-edit-001 con este punto final.

•input (string - opcional): El texto de entrada a utilizar como punto de partida para la edición.

•instruction (string - Obligatorio): El sufijo que se agrega después de la finalización del texto insertado.

•temperature (float - opcional): La temperatura de muestreo a utilizar, entre 0 y 2. Valores más altos como 0.8 harán que la salida sea más aleatoria, mientras que valores más bajos como 0.2 la harán más enfocada y determinista.

•top_p (float - opcional): Una alternativa al muestreo con temperatura, llamada muestreo de núcleo, donde el modelo considera los resultados de los tokens con la probabilidad acumulada de top_p. Por ejemplo, 0.1 significa que solo se consideran los tokens que comprenden el 10% superior de la probabilidad acumulada.

•n (int - opcional): Cuántas ediciones generar para la entrada e instrucción.

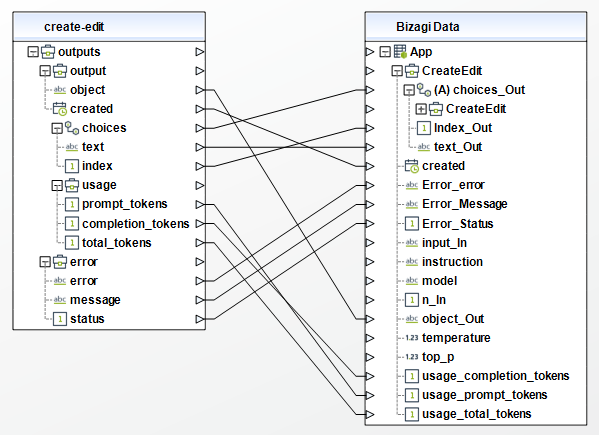

Para configurar las salidas de esta acción, puedes asignar el objeto de salida a la entidad correspondiente en Bizagi y asegurarte de asignar adecuadamente los atributos de la entidad.

Las salidas de este conector son las siguientes:

•object (string): Indica el tipo de objeto devuelto, en este caso, será "edición".

•created (date): Fecha de creación de la respuesta.

•choices (object - array):

oindex (int): Número para identificar el elemento actual respondido.

otext (string): Respuesta a la pregunta a partir de las entradas.

•usage (object):

otokens_prompt (int): Tokens utilizados en la respuesta.

ocompletition_tokens (int): Tokens utilizados en la finalización.

ototal_tokens (int): Total de tokens utilizados.

Crear moderación

Determina si la entrada del usuario pertenece o no a una de las categorías restringidas. Estas categorías se muestran a continuación.

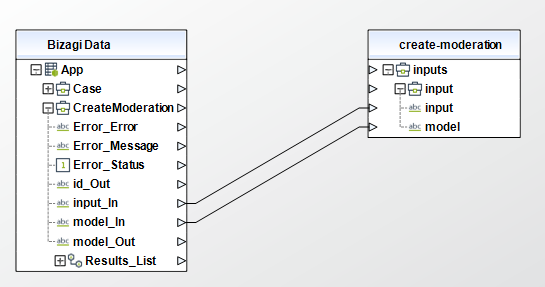

Para configurar sus entradas, ten en cuenta las siguientes descripciones:

•input (string - Obligatorio): El texto de entrada a clasificar.

•model (string - opcional): Hay dos modelos de moderación de contenido disponibles: text-moderation-stable y text-moderation-latest.

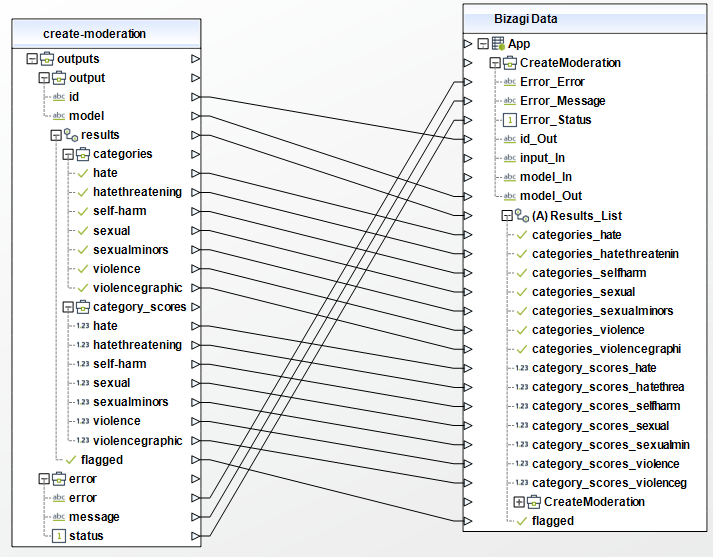

Para configurar las salidas de esta acción, puedes asignar el objeto de salida a la entidad correspondiente en Bizagi y asegurarte de asignar adecuadamente los atributos de la entidad.

Las salidas de este conector son las siguientes:

•id (string): Identificador de salida.

•model (string): Modelo utilizado.

•results (objecto - array): Resultados como valor booleano o puntuación decimal.

ocategories (object): Los valores booleanos se encuentran en esta lista y determinan si la entrada del usuario pertenece a cada categoría restringida. Las categorías son (hate, hatethreatening, self-harm, sexual, sexualminors, violence, violencegraphic).

ocategory_scores (object): Los valores decimales se encuentran en esta lista y determinan la probabilidad de coincidencia para cada categoría restringida. Las categorías son (hate, hatethreatening, self-harm, sexual, sexualminors, violence, violencegraphic).

oflagged (boolean): Determina si el contenido fue marcado con moderación o no.

Last Updated 6/26/2023 4:22:36 PM